检测¶

MXNet Pytorch

MXNet¶

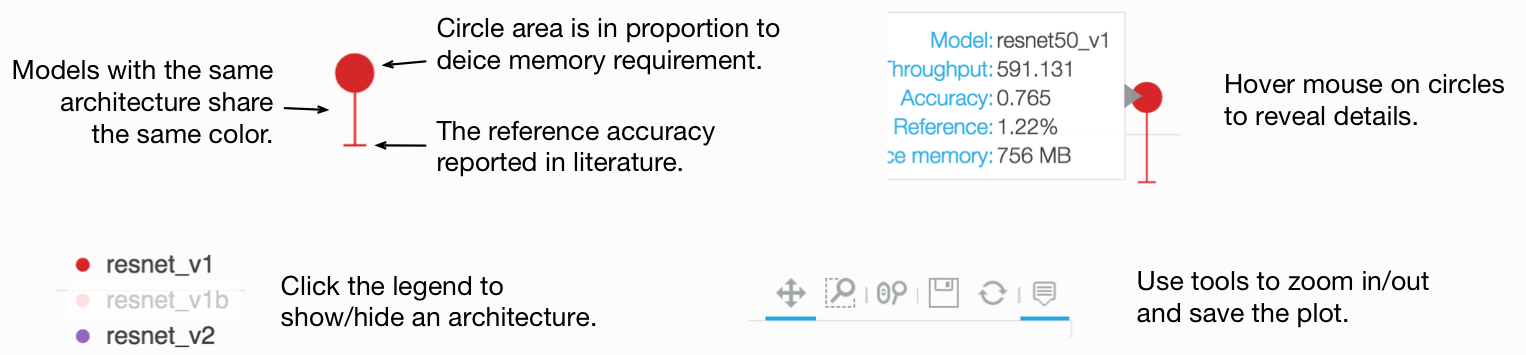

第一张图展示了 COCO 预训练模型的推理吞吐量与验证 mAP 的可视化比较。

我们还提供了所有 80 个目标类别的详细交互式分析。

下表列出了用于目标检测的预训练模型及其性能详情。

提示

模型属性编码在其名称中。例如,ssd_300_vgg16_atrous_voc 由四个部分组成

ssd表示算法为“Single Shot Multibox Object Detection” 1。300是训练图像尺寸,意味着训练图像被缩放到 300x300,并且所有锚框都设计为匹配此形状。这可能不适用于某些模型。vgg16_atrous是基础特征提取网络的类型。voc是训练数据集。您可以选择voc或coco等。(320x320)表示模型在 320x320 分辨率下进行评估。除非另有说明,GluonCV 中的所有检测模型都可以接受各种输入形状进行预测。一些模型使用各种输入数据形状进行训练,例如 Faster-RCNN 和 YOLO 模型。ssd_300_vgg16_atrous_voc_int8是在 Pascal VOC 数据集上校准的ssd_300_vgg16_atrous_voc的量化模型。

提示

训练命令与以下脚本一起使用

对于 SSD 1 网络:

下载 train_ssd.py对于 Faster-RCNN 2 网络:

下载 train_faster_rcnn.py对于 YOLO v3 3 网络:

下载 train_yolo3.py

PASCAL VOC¶

提示

对于 PASCAL VOC 数据集,训练图像集是 2007trainval 和 2012trainval 的并集,验证图像集是 2007test。

报告了 VOC 指标,即所有类别的平均精度 (mAP),IoU 阈值为 0.5。

量化 SSD 模型使用 nms_thresh=0.45 和 nms_topk=200 进行评估。

SSD¶

在此处查看 SSD 演示教程:01. 使用预训练 SSD 模型进行预测

模型 |

mAP |

训练命令 |

训练日志 |

|---|---|---|---|

ssd_300_vgg16_atrous_voc 1 |

77.6 |

||

ssd_300_vgg16_atrous_voc_int8* 1 |

77.46 |

||

ssd_512_vgg16_atrous_voc 1 |

79.2 |

||

ssd_512_vgg16_atrous_voc_int8* 1 |

78.39 |

||

ssd_512_resnet50_v1_voc 1 |

80.1 |

||

ssd_512_resnet50_v1_voc_int8* 1 |

80.16 |

||

ssd_512_mobilenet1.0_voc 1 |

75.4 |

||

ssd_512_mobilenet1.0_voc_int8* 1 |

75.04 |

Faster-RCNN¶

VOC 数据集的 Faster-RCNN 模型使用原生分辨率进行评估,要求较短边 >= 600 且较长边 <= 1000,同时保持纵横比不变。

在此处查看 Faster-RCNN 演示教程:02. 使用预训练 Faster RCNN 模型进行预测

模型 |

mAP |

训练命令 |

训练日志 |

|---|---|---|---|

faster_rcnn_resnet50_v1b_voc 2 |

78.3 |

YOLO-v3¶

YOLO-v3 模型可以在不同分辨率下进行评估和预测。不同评估分辨率下报告的 mAP 不同,但模型是相同的。

在此处查看 YOLO 演示教程:03. 使用预训练 YOLO 模型进行预测

模型 |

mAP |

训练命令 |

训练日志 |

|---|---|---|---|

yolo3_darknet53_voc 3 (320x320) |

79.3 |

||

yolo3_darknet53_voc 3 (416x416) |

81.5 |

||

yolo3_mobilenet1.0_voc 3 (320x320) |

73.9 |

||

yolo3_mobilenet1.0_voc 3 (416x416) |

75.8 |

CenterNet¶

CenterNet 模型在 512x512 分辨率下进行评估。同时报告了使用翻转推理 (F) 的 mAP,但模型是相同的。在此处查看 CenterNet 演示教程:11. 使用预训练 CenterNet 模型进行预测

请注意,dcnv2 表示模型包含调制可变形卷积 (Modulated Deformable Convolution) (DCNv2) 层,您可能需要升级 MXNet 才能使用它们。

模型 |

mAP (原始/翻转) |

训练命令 |

训练日志 |

|---|---|---|---|

center_net_resnet18_v1b_voc 6 |

66.8/69.5 |

||

center_net_resnet18_v1b_dcnv2_voc 6 |

71.2/74.7 |

||

center_net_resnet50_v1b_voc 6 |

71.8/76.1 |

||

center_net_resnet50_v1b_dcnv2_voc 6 |

75.6/78.7 |

||

center_net_resnet101_v1b_voc 6 |

75.5/78.2 |

||

center_net_resnet101_v1b_dcnv2_voc 6 |

76.7/79.2 |

MS COCO¶

提示

对于 COCO 数据集,训练图像集是 train2017,验证图像集是 val2017。

COCO 指标,即 IoU 阈值 0.5:0.95 的平均精度 (AP)(10 个值的平均值,AP 0.5:0.95)、0.5 (AP 0.5) 和 0.75 (AP 0.75) 以 (AP 0.5:0.95)/(AP 0.5)/(AP 0.75) 的格式一起报告。

对于目标检测任务,只评估和报告基于边界框重叠的 AP。

SSD¶

在此处查看 SSD 演示教程:01. 使用预训练 SSD 模型进行预测

模型 |

边界框 AP |

训练命令 |

训练日志 |

|---|---|---|---|

ssd_300_vgg16_atrous_coco 1 |

25.1/42.9/25.8 |

||

ssd_512_vgg16_atrous_coco 1 |

28.9/47.9/30.6 |

||

ssd_300_resnet34_v1b_coco 1 |

25.1/41.7/26.2 |

||

ssd_512_resnet50_v1_coco 1 |

30.6/50.0/32.2 |

||

ssd_512_mobilenet1.0_coco 1 |

21.7/39.2/21.3 |

Faster-RCNN¶

VOC 数据集的 Faster-RCNN 模型使用原生分辨率进行评估,要求较短边 >= 800 且较长边 <= 1333,同时保持纵横比不变。

在此处查看 Faster-RCNN 演示教程:02. 使用预训练 Faster RCNN 模型进行预测

模型 |

边界框 AP |

训练命令 |

训练日志 |

|---|---|---|---|

faster_rcnn_resnet50_v1b_coco 2 |

37.0/57.8/39.6 |

||

faster_rcnn_resnet101_v1d_coco 2 |

40.1/60.9/43.3 |

||

faster_rcnn_fpn_resnet50_v1b_coco 4 |

38.4/60.2/41.6 |

||

faster_rcnn_fpn_resnet101_v1d_coco 4 |

40.8/62.4/44.7 |

||

faster_rcnn_fpn_bn_resnet50_v1b_coco 5 |

39.3/61.3/42.9 |

||

faster_rcnn_fpn_syncbn_resnest50_coco 7 |

42.7/64.1/46.4 |

||

faster_rcnn_fpn_syncbn_resnest101_coco 7 |

44.9/66.4/48.9 |

||

faster_rcnn_fpn_syncbn_resnest269_coco 7 |

46.5/67.5/50.7 |

YOLO-v3¶

YOLO-v3 模型可以在不同分辨率下进行评估和预测。不同评估分辨率下报告的 mAP 不同。

在此处查看 YOLO 演示教程:03. 使用预训练 YOLO 模型进行预测

模型 |

边界框 AP |

训练命令 |

训练日志 |

|---|---|---|---|

yolo3_darknet53_coco 3 (320x320) |

33.6/54.1/35.8 |

||

yolo3_darknet53_coco 3 (416x416) |

36.0/57.2/38.7 |

||

yolo3_darknet53_coco 3 (608x608) |

37.0/58.2/40.1 |

||

yolo3_mobilenet1.0_coco 3 (320x320) |

26.7/46.1/27.5 |

||

yolo3_mobilenet1.0_coco 3 (416x416) |

28.6/48.9/29.9 |

||

yolo3_mobilenet1.0_coco 3 (608x608) |

28.0/49.8/27.8 |

CenterNet¶

CenterNet 模型在 512x512 分辨率下进行评估。同时报告了使用翻转推理 (F) 的 mAP,但模型是相同的。在此处查看 CenterNet 演示教程:11. 使用预训练 CenterNet 模型进行预测。

请注意,dcnv2 表示模型包含调制可变形卷积 (Modulated Deformable Convolution) (DCNv2) 层,您可能需要升级 MXNet 才能使用它们。

模型 |

mAP (原始/翻转) |

训练命令 |

训练日志 |

|---|---|---|---|

center_net_resnet18_v1b_coco 6 |

26.6/28.1 |

||

center_net_resnet18_v1b_dcnv2_coco 6 |

28.9/30.3 |

||

center_net_resnet50_v1b_coco 6 |

32.1/33.4 |

||

center_net_resnet50_v1b_dcnv2_coco 6 |

34.0/35.3 |

||

center_net_resnet101_v1b_coco 6 |

34.5/35.8 |

||

center_net_resnet101_v1b_dcnv2_coco 6 |

35.8/37.1 |

PyTorch¶

使用 PyTorch 实现的模型将在稍后添加。请暂时查看我们的 MXNet 实现。

参考¶

- 1(1,2,3,4,5,6,7,8,9,10,11,12,13,14,15)

Wei Liu, Dragomir Anguelov, Dumitru Erhan, Christian Szegedy, Scott Reed, Cheng-Yang Fu, Alexander C. Berg. SSD: 单次多盒检测器。ECCV 2016.

- 2(1,2,3,4)

Ren, Shaoqing, Kaiming He, Ross Girshick, and Jian Sun. “Faster R-CNN: 基于区域提议网络实现实时目标检测。” In Advances in neural information processing systems, pp. 91-99. 2015.

- 3(1,2,3,4,5,6,7,8,9,10,11)

Redmon, Joseph, and Ali Farhadi. “Yolov3: 渐进式改进。” arXiv preprint arXiv:1804.02767 (2018).

- 4(1,2)

Tsung-Yi Lin, Piotr Dollár, Ross Girshick, Kaiming He, Bharath Hariharan, Serge Belongie. “用于目标检测的特征金字塔网络。” IEEE Conference on Computer Vision and Pattern Recognition 2017.

- 5

Kaiming He, Ross Girshick, Piotr Dollár. “重新思考 ImageNet 预训练。” arXiv preprint arXiv:1811.08883 (2018).

- 6(1,2,3,4,5,6,7,8,9,10,11,12)

Zhou, Xingyi, Dequan Wang, and Philipp Krähenbühl. “将目标视为点。” arXiv preprint arXiv:1904.07850 (2019).

- 7(1,2,3)

Hang Zhang, Chongruo Wu, Zhongyue Zhang, Yi Zhu, Zhi Zhang, Haibin Lin, Yue Sun, Tong He, Jonas Muller, R. Manmatha, Mu Li and Alex Smola “ResNeSt: 分割注意力网络” arXiv preprint (2020).