姿态估计¶

MXNet Pytorch

MXNet¶

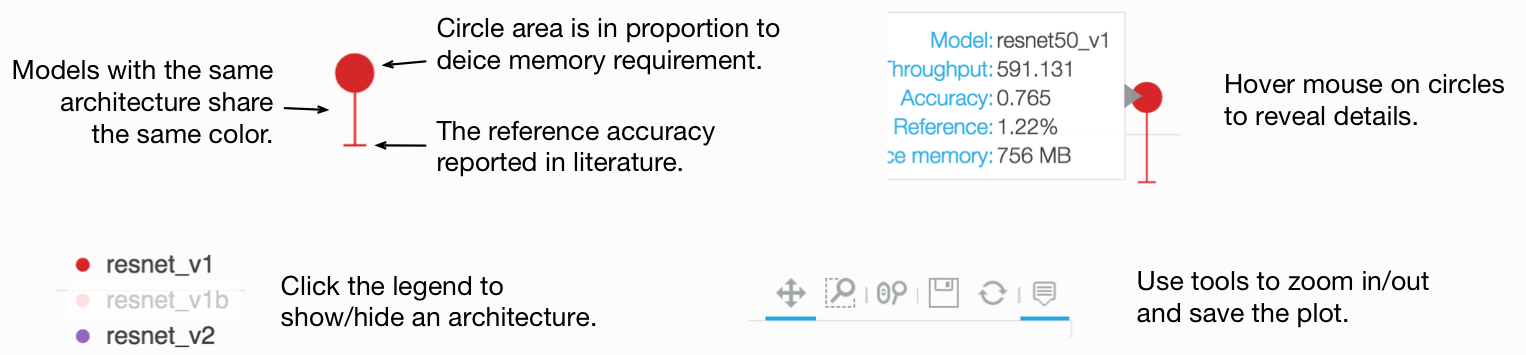

下图展示了 COCO 预训练模型的推理吞吐量与验证 AP 的对比可视化。吞吐量使用单张 V100 GPU 和批量大小 64 进行测量。

注意

姿态估计在 GluonCV 0.4 版本中发布。请务必通过 pip install gluoncv --upgrade 更新您的安装以尝试新功能。

MS COCO 关键点¶

提示

对于 COCO 数据集,训练图像集是 train2017,验证图像集是 val2017。

COCO 指标,即 IoU 阈值为 0.5:0.95 的平均精度 (AP)(10 个值的平均值,AP 0.5:0.95)、0.5 (AP 0.5) 和 0.75 (AP 0.75),以 (AP 0.5:0.95)/(AP 0.5)/(AP 0.75) 的格式一起报告。

COCO 关键点指标评估对象关键点相似度 AP。请阅读官方文档以获取详细介绍。

通过平均原始输入和翻转输入的预测结果,我们可以获得更高的性能。这里我们报告了使用和不使用翻转集成的预测性能。

基于 ResNet 的 Simple Pose¶

请在此处查看演示教程:1. 使用 Simple Pose Estimation 预训练模型进行预测

大多数模型使用 256x192 的输入尺寸进行训练,除非另有说明。带有灰色名称的参数可以通过传递相应的哈希标签进行下载。

下载默认预训练权重:

net = get_model('simple_pose_resnet152_v1d', pretrained=True)下载指定哈希标签的权重:

net = get_model('simple_pose_resnet152_v1d', pretrained='2f544338')

模型 |

OKS AP |

OKS AP (带翻转) |

哈希标签 |

训练命令 |

训练日志 |

|---|---|---|---|---|---|

simple_pose_resnet18_v1b 1 |

66.3/89.2/73.4 |

68.4/90.3/75.7 |

f63d42ac |

||

simple_pose_resnet18_v1b 1 (128x96) |

52.8/83.6/57.9 |

54.5/84.8/60.3 |

ccd24037 |

||

simple_pose_resnet50_v1b 1 |

71.0/91.2/78.6 |

72.2/92.2/79.9 |

e2c7b1ad |

||

simple_pose_resnet50_v1d 1 |

71.6/91.3/78.7 |

73.3/92.4/80.8 |

ba2675b6 |

||

simple_pose_resnet101_v1b 1 |

72.4/92.2/79.8 |

73.7/92.3/81.1 |

b7ec0de1 |

||

simple_pose_resnet101_v1d 1 |

73.0/92.2/80.8 |

74.2/92.4/82.0 |

1f8f48fd |

||

simple_pose_resnet152_v1b 1 |

72.4/92.1/79.6 |

74.2/92.3/82.1 |

ef4e0336 |

||

simple_pose_resnet152_v1d 1 |

73.4/92.3/80.7 |

74.6/93.4/82.1 |

3ca502ea |

||

simple_pose_resnet152_v1d 1 (384x288) |

74.8/92.3/82.0 |

76.1/92.4/83.2 |

2f544338 |

移动端姿态模型¶

通过替换骨干网络,并使用 pixel shuffle 层代替反卷积,我们可以得到非常快速的模型。

这些模型适用于边缘设备应用,部署教程将很快推出。

模型使用 256x192 的输入尺寸进行训练,除非另有说明。

模型 |

OKS AP |

OKS AP (带翻转) |

哈希标签 |

训练命令 |

训练日志 |

|---|---|---|---|---|---|

mobile_pose_resnet18_v1b 1 |

66.2/89.2/74.3 |

67.9/90.3/75.7 |

dd6644eb |

||

mobile_pose_resnet50_v1b 1 |

71.1/91.3/78.7 |

72.4/92.3/79.8 |

ec8809df |

||

mobile_pose_mobilenet1.0 1 |

64.1/88.1/71.2 |

65.7/89.2/73.4 |

b399bac7 |

||

mobile_pose_mobilenetv2_1.0 1 |

63.7/88.1/71.0 |

65.0/89.2/72.3 |

4acdc130 |

||

mobile_pose_mobilenetv3_large 1 |

63.7/88.9/70.8 |

64.5/89.0/72.0 |

1ca004dc |

||

mobile_pose_mobilenetv3_small 1 |

54.3/83.7/59.4 |

55.6/84.7/61.7 |

b1b148a9 |

AlphaPose¶

请在此处查看演示教程:2. 使用 AlphaPose Estimation 预训练模型进行预测

除非另有说明,Alpha Pose 模型使用 (320*256) 的输入尺寸进行评估。用法类似于 Simple Pose 部分。

模型 |

OKS AP |

OKS AP (带翻转) |

哈希标签 |

训练命令 |

训练日志 |

|---|---|---|---|---|---|

alpha_pose_resnet101_v1b_coco 2 |

74.2/91.6/80.7 |

76.7/92.6/82.9 |

de56b871 |

PyTorch¶

使用 PyTorch 实现的模型将在稍后添加。请参阅我们的 MXNet 实现。

参考文献¶

- 1(1,2,3,4,5,6,7,8,9,10,11,12,13,14,15,16)

Xiao, Bin, Haiping Wu, and Yichen Wei. “Simple baselines for human pose estimation and tracking.” Proceedings of the European Conference on Computer Vision (ECCV). 2018.

- 2

Fang, Hao-Shu, et al. “Rmpe: Regional multi-person pose estimation.” Proceedings of the IEEE International Conference on Computer Vision. 2017.